Diese Website verwendet Cookies, damit wir dir die bestmögliche Benutzererfahrung bieten können. Cookie-Informationen werden in deinem Browser gespeichert und führen Funktionen aus, wie das Wiedererkennen von dir, wenn du auf unsere Website zurückkehrst, und hilft unserem Team zu verstehen, welche Abschnitte der Website für dich am interessantesten und nützlichsten sind.

Kunde

Für ein innovatives Technologie-Startup haben wir eine Lösung für die Modebranche entwickelt. Sie wurde als Add-on konzipiert, das die Möglichkeiten der meisten bestehenden Plattformen erweitert und somit perfekt auf die Bedürfnisse des modernen E-Commerce-Marktes abgestimmt ist. Sie ist für Einzelkunden gedacht, die Kleidung anprobieren möchten, bevor sie gekauft und geliefert wird.

Herausforderung

Die E-Commerce-Branche steht heute vor der Herausforderung, eine große Anzahl von Rücksendungen zu akzeptieren. Die Rücksendung ist kostspielig und zeitaufwändig. Daher wurde ein Tool benötigt, das die Wahrscheinlichkeit der Rücksendung von anprobierten Kleidungsstücken verringert, die Konversionsrate verbessert und die Kosten senkt.

Die größte Herausforderung bestand darin, ein Produkt zu entwickeln, das das realistische Aussehen bestimmter Personen und der Kleidung, die sie anprobieren, nachbildet (verschiedene Größen, Aufdrucke, Schnitte, Details). Je genauer ein solches Modell hergestellt wird, desto häufiger wird es von den App-Nutzern verwendet werden.

Lösung

Der gesamte Prozess umfasste die folgenden Phasen der Modellentwicklung

1. Wir haben mit dem Kunden das Ziel des Projekts definiert, sowohl in geschäftlicher als auch technischer Hinsicht.

Ziel war es, eine Lösung zu entwickeln, die auf mehreren kollaborativen Modellen basiert, wobei davon ausgegangen wird, dass die verfügbaren Daten ein Silhouettenfoto der anprobierenden Person und ein Foto des anprobierten Kleidungsstücks sind.

2. Wir sammelten und extrahierten die relevanten Daten gesammelt.

In diesem Stadium haben wir die relevanten Merkmale der Person und der Kleidung extrahiert. Keines der Merkmale ermöglicht eine biometrische Identifizierung, sodass die Lösung sicher ist und nicht den Einschränkungen des AI-Gesetzes unterliegt.

3. Die Daten wurden verwendet, um jedes der Modelle separat zu trainieren. Die aus einem Modell resultierenden Daten dienten als Grundlage für die Leistung der nachfolgenden Modelle.

Anhand der gesammelten Daten in Form von entsprechend aufbereiteten Bildern haben wir eine realistische Visualisierung des Avatars des Benutzers in der anprobierten Kleidung erstellt.

4. Das Modell wurde implementiert und unter verschiedenen Bedingungen getestet.

Damit der Nutzer die Kleidung, die er anprobiert, am besten einschätzen kann, präsentiert die Lösung eine Visualisierung in verschiedenen Avatar-Posen.

Dabei haben wir Technologien wie diese eingesetzt:

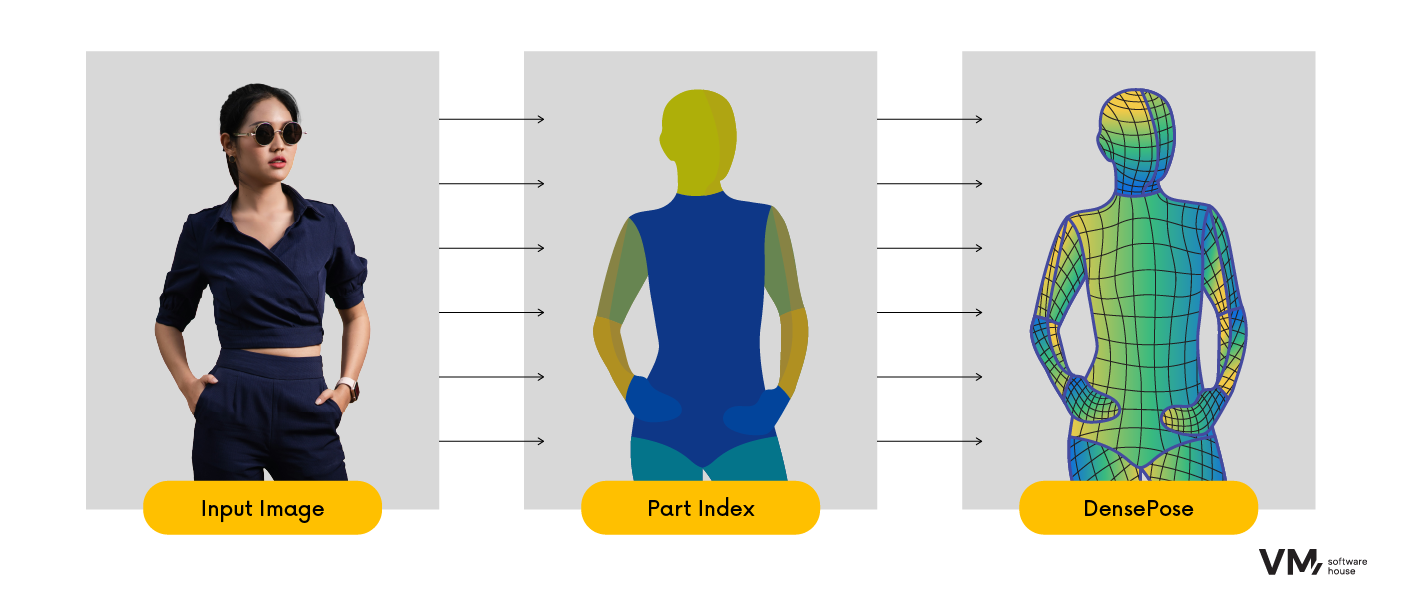

- DensePose – die Strategie besteht darin, die Entfernung einer Person zu schätzen, indem ihre Oberfläche als Grundlage genommen wird. Für jedes Pixel wird bestimmt, zu welchem Teil der Oberfläche es gehört, wo es sich in der 2D-Parametrisierung befindet und welchem Teil es entspricht. Auf der rechten Seite sind die Flächenaufteilung und die „Punkt-zu-Teil-Korrespondenz“ dargestellt. Die Interpretation dieses Modells besteht darin, die äußere Schicht des 3D-Objekts zu „entfernen“ und sie an die entsprechenden Stellen im flachen Bild zu strecken.

- Segmentierung (Computer Vision) – Ein Bild wird in mehrere Segmente oder Objekte unterteilt, die zur selben Klasse gehören. Diese Gruppierungsaufgabe basierte auf bestimmten Kriterien, z. B. Farbe oder Textur. In diesem speziellen Fall waren wir daran interessiert, Körperteile und Kleidungsstücke zu extrahieren, um die Kleidung für die Benutzer des Systems korrekt anzuprobieren.

- Koordinatenvervollständigungsmodell – Wir haben ein Modell verwendet, das die durch das DensePose-Modell entstandenen Lücken vervollständigt. Als Ergebnis haben wir die erste Version des Benutzers in der neuen Kleidung aus jedem möglichen Winkel, sodass er in jeder Pose gezeigt werden kann.

- GAN (Generative Adversarial Networks) für die generative Modellierung mithilfe von Deep-Learning-Methoden wie neuronalen Netzen. Dadurch können Regelmäßigkeiten oder Muster in den Eingabedaten so erlernt werden, dass das Modell dazu verwendet werden kann, neue Beispiele zu generieren oder zu präsentieren, die aus dem ursprünglichen Datensatz hätten gezogen werden können.

GAN-Modelle zeichnen sich dadurch aus, dass sie mit bestimmten Inputs und Outputs beauftragt werden können, d. h., wenn wir dir zu Beginn „A“ und „B“ geben, dann wollen wir, dass du „C“ machst. Dies ist mithilfe der heute so beliebten StableDiffiusion nicht möglich. Unser As und Bs waren also das Foto des Benutzers, das Ergebnis des CCM, die Segmentierung, die eingestellte Pose und die Kleidung, und das Ergebnis der Aktivität war ein angekleideter Benutzer in der Kleidung seiner Wahl.

Ergebnisse

Wir konnten hochauflösende Visualisierungen des anprobierten Kleidungsstücks erstellen, außerdem Reproduktionen von Drucken und anderen dekorativen Elementen.

Design, Entwicklung, DevOps oder Cloud - welches Team brauchen Sie, um die Arbeit an Ihren Projekten zu beschleunigen?

Chatten Sie mit unseren Beratungspartnern, um herauszufinden, ob wir gut zusammenpassen.