Jeder CTO (Chief Technology Officer) ist sich bewusst, dass Software so geschrieben werden sollte, dass sie leicht skalierbar ist. Die Berücksichtigung dieses Aspekts im Softwareentwicklungsprozess ermöglicht die volle Nutzung der verfügbaren Ressourcen und eine hohe Leistung. Wie lassen sich die Kosten bei einer Anwendungsskalierung so abschätzen und kontrollieren, dass sie nicht mehr leisten kann, und dabei gleichzeitig das Budget schont?

Angesichts knapper IT-Budgets und des Kostendrucks, dem Unternehmen ausgesetzt sind, wird die Wartung und Verwaltung skalierter Anwendungen zu einer echten Herausforderung. Laut Pluralsight können die Kosten für Systemverwaltung, Überwachung, Backup und Upgrades bis zu 20-30 % des gesamten IT-Budgets ausmachen.

Bedeutet dies, dass Sie sofort teure Skalierungsstrategien umsetzen müssen? Keineswegs. Viele erfahrene Führungskräfte haben festgestellt, dass die kosteneffiziente Skalierung von Anwendungen der Schlüssel zum Erfolg ist.

Inhaltsverzeichnis

Was ist Anwendungsskalierung?

Skalierbarkeit bezieht sich auf die Fähigkeit der Anwendung, eine zunehmende Last von mehr Benutzern, Daten oder andere Ressourcen zu bewältigen, ohne dass die Leistung oder Zuverlässigkeit signifikant abnimmt. In der Welt der Anwendungen hängen diese Bedingungen von der Menge der Daten oder der Anzahl der Vorgänge ab, die zu einem bestimmten Zeitpunkt verarbeitet werden müssen. Es geht darum, die Infrastruktur, auf der die Anwendung läuft, so vorzubereiten, dass sie all diese Belastungen bewältigen kann.

Daher müssen Sie bei der Entwicklung einer Anwendung darauf achten, dass sie eine größere Anzahl von Benutzern unterstützt und gleichzeitig eine gleichbleibende Leistung bietet. Dies spart langfristig Geld, da so nicht so viele größere Änderungen und Upgrades erforderlich sind.

Es ist notwendig, skalierbare Technologien und Infrastrukturen zu verwenden, wie z. B. Cloud-basierte Lösungen oder eine Microservices-Architektur, damit eine Anwendung mit der Zeit wachsen kann.

Kommen wir nun also zu den fünf Faktoren, die für eine erfolgreiche Systemskalierung unerlässlich sind.

1. Kennen Sie die Anforderungen an Ihr System

Der erste Schritt zur Abschätzung und Kontrolle der Kosten von Cloud-Anwendungen besteht darin, Ihre Skalierungsanforderungen zu verstehen.

Auch hier lohnt es sich, Fragen zu stellen:

- Was sind die Ziele des Projekts – Art, Umfang und Komplexität der Anwendung, z. B. Welche Antwortzeit ist akzeptabel? Wie viel werde ich ausgeben, um die Antwortzeit zu halbieren? Ist die Anwendung so konzipiert, dass dies überhaupt möglich ist?

- Müssen alle Teile meines Systems und alle Funktionen gleich effizient sein, oder braucht nur ein Teil der Funktionalität mehr Effizienz? Wenn der Teil des Typs eine höhere Leistung erfordert, ist es eine gute Idee, ihn bereits auf dieser Ebene zu benennen. Das spart Kosten in der Implementierungsphase.

- Kenne ich meine größten Kostentreiber? Nicht nur Server, sondern auch Daten und Nutzungsmuster.

- Haben wir definierte Skalierungsmetriken, wie CPU-Nutzung, Speichernutzung, Antwortzeit oder Durchsatz?

Diese erste Phase der Analyse ist entscheidend. Viele CTOs betonen, dass man für MVP-Forschung und -Entwicklung zu viel Geld ausgeben kann, indem man “vorskaliert”, aber das Ziel nicht erreicht.

Das passiert, wenn wir in Skalierungsfunktionen investieren, die wir nicht brauchen, oder zu früh, bevor wir tatsächliche Einnahmen erzielen. Andererseits ist es notwendig, das Verkehrswachstum zu antizipieren, da das Fehlen eines Plans zur Abwanderung unzufriedener App-Nutzer führen kann.

2. Finden Sie Engpässe in der Anwendung

Bevor wir Skalierungsstrategien entwickeln, müssen wir die Punkte ermitteln, die die Anwendungsleistung einschränken können. Es gibt drei grundlegende Engpässe für jede Website:

- Mangelnde Prozessorleistung, um die Anzahl der Benutzer zu bewältigen,

- mangelder Speicherplatz für die Durchführung von Operationen mit den zu diesem Zweck benötigten Daten,

- mangelnder Input/Output, um Daten schnell genug zu versenden.

Wenn Sie eines dieser drei Elemente erhöhen, wird eines der anderen Elemente irgendwann nicht mehr ausreichen, um mehr Verkehr zu bewältigen. Um diese Herausforderungen zu bewältigen, können Sie eine vertikale oder horizontale Skalierung angehen.

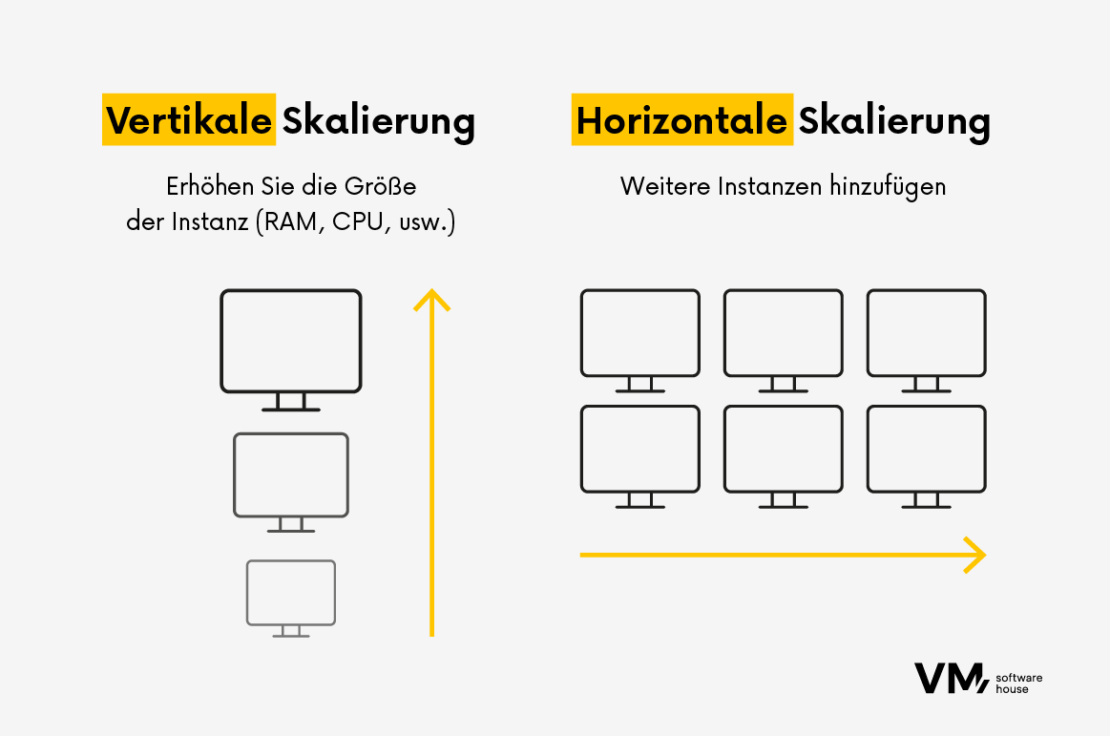

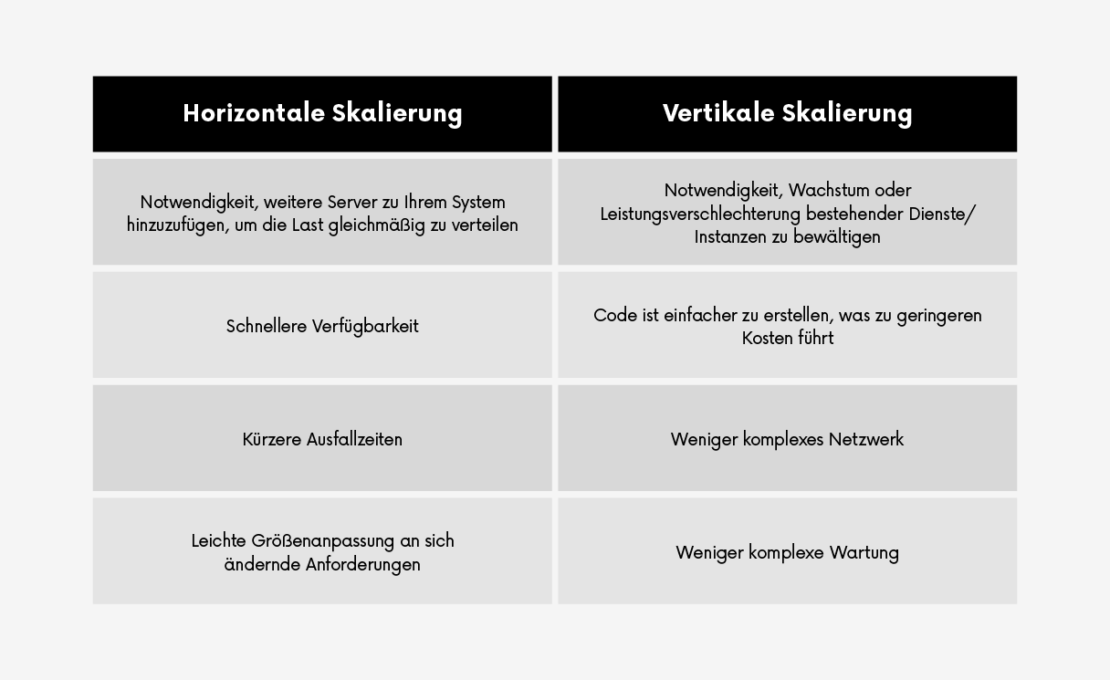

Horizontale Skalierung vs. vertikale Skalierung

Vertikale Skalierung, auch bekannt als Auf- oder Abwärtsskalierung, lässt sich durch die Erhöhung der Kapazität eines bestehenden Servers durch Hinzufügen von mehr Leistung erreichen. Dies ist eine schnelle Lösung, die jedoch ihre Grenzen hat.

Wie bei Desktop-PCs kann der Server durch einen besseren Prozessor, mehr Arbeitsspeicher oder eine SSD aufgerüstet werden. Eine höhere Prozessor-, des Arbeitsspeicher- und Operationsleistung erhöht in der Regel auch die Anzahl der Nutzer, die unterstützt werden können.

Doch irgendwann taucht ein Problem auf: Es wird immer schwieriger und teurer, einen größeren Server zu erstellen. Die Einstellung von Mitarbeitern, die Leistungsprobleme im Code finden und beheben sollen, ist in der Regel sehr zeitaufwändig, und diese Zeit wird nicht dafür verwendet, neue Funktionen oder andere Dinge hinzuzufügen, die neue Nutzer anziehen könnten.

Daher wird in den meisten Fällen eine horizontale Skalierung vorgenommen, bei der weitere Server hinzugefügt werden. Dieser Ansatz ist flexibler und kostengünstiger, erfordert aber eine sorgfältige Architektur, um die Komplexität zu beherrschen.

Dienste, die die Skalierung automatisieren, verwenden meist eine horizontale Skalierung. Cloud-Dienste wie Heroku, AWS Auto Scaling usw. fügen bei steigendem Datenverkehr dynamisch neue Server hinzu und skalieren sie dann proportional herunter.

Die Wahl zwischen horizontaler und vertikaler Skalierung hängt von der Komplexität der Anwendung ab: Die vertikale Skalierung eignet sich für einfachere, weniger integrierte Anwendungen. Im Gegensatz dazu ist die horizontale Skalierung besser für komplexe Anwendungen mit mehreren Microservices oder miteinander verbundenen Systemen geeignet.

3. Wählen Sie die richtige Skalierungsstrategie

Die Anwendungsskalierung sollte so flexibel sein, dass sie je nach Arbeitslast automatisch nach oben oder unten skaliert werden kann, um eine hohe Verfügbarkeit der Anwendung zu gewährleisten und gleichzeitig die Kosten zu senken.

Nun werden wir einige Skalierungstechniken erörtern, die Sie bei der Optimierung Ihrer Anwendung berücksichtigen sollten.

1. Lastverteilung

Die Lastverteilung verteilt den eingehenden Datenverkehr auf mehrere Server, um sicherzustellen, dass kein einzelner Server überlastet wird. Dies erhöht die Ressourcenauslastung, maximiert den Durchsatz und minimiert die Reaktionszeit. Beliebte Strategien sind:

- Round Robin: Sequentielle Verteilung der Anfragen an jeden Server.

- Geringste Verbindungen: Leitet Anfragen an den Server mit den wenigsten Verbindungen.

- IP-Hash: Leiten Sie Anfragen von derselben IP-Adresse an denselben Server weiter, um die Aufrechterhaltung von Sitzungen zu gewährleisten.

2. Aufteilung der Datenbank

Beim Sharding von Datenbanken wird ein einzelner Datensatz auf mehrere Datenbanken (Shards) verteilt. Dadurch werden Leseanfragen auf mehrere Datenbanken verteilt und die Belastung der einzelnen Datenbanken durch die Verteilung von Lese- und Schreibvorgängen verringert.

3. Einführung von Cache

Bei der Zwischenspeicherung werden Kopien häufig verwendeter Daten in einem Hochgeschwindigkeitsspeicher abgelegt, um sie schnell abrufen zu können. Es gibt verschiedene Arten des Caching:

- Verringerung der redundanten Datenoperationen.

- Zwischenspeichern ganzer HTML-Seiten, um wiederholtes Rendern zu vermeiden.

4. Microservices-Architektur

Microservices unterteilen Anwendungen in unabhängige Komponenten, die sich jeweils auf eine bestimmte Funktion konzentrieren. Bei einem solchen Beispiel von Microservices geht es bei der Skalierbarkeit darum, mehrere Instanzen derselben Software auszuführen und den Datenverkehr auf sie zu verteilen. Aufgrund des hohen Verkehrsaufkommens müssen sie zuverlässig, aber immer verfügbar und respektvoll sein, um die Leistung nicht zu beeinträchtigen.

Beispiele für Microservices, die in vielen gängigen Anwendungen zu finden sind, sind:

- Suchfunktionen

- Microservices für die Dokumentenerstellung

- Microservices für Autorisierung und Authentifizierung

Zu den Vorteilen des Einsatzes von Microservices gehören eine bessere Systemleistung, eine einfachere Verwaltung der Softwarearchitektur, eine Skalierung auf der Ebene eines bestimmten Dienstes statt des gesamten Systems und ein geringeres Fehlerrisiko in anderen Modulen. All dies schlägt sich in niedrigeren Entwicklungskosten nieder.

5. Asynchrone Verarbeitung

Die asynchrone Verarbeitung ermöglicht die Bearbeitung von Aufgaben unabhängig vom Hauptanwendungs-Thread. Durch die Auslagerung schwerer Operationen, wie z. B. das Hochladen von Bildern, auf Hintergrundprozesse werden Ressourcen für Echtzeitaufgaben frei.

6. Automatische Skalierung

Die automatische Skalierung passt die Ressourcen dynamisch an den Echtzeitbedarf an. Die Dienste sind auf AWS- und Google Cloud-Plattformen verfügbar. Lösungen wie AWS Auto Scaling oder die Compute Engine von Google Cloud bieten Lösungen zur automatischen Skalierung von Ressourcen nach oben oder unten, um eine optimale Leistung zu erzielen, die zur Kostenoptimierung für Cloud-basierte Dienste beitragen kann.

7. Open-Source-In-Memory-Computing

Open-Source-Lösungen für In-Memory-Computing wie Apache Ignite bieten eine kostengünstige Möglichkeit, ein System zu skalieren und gleichzeitig die Latenzzeit schnell zu reduzieren.

Apache Ignite kombiniert verfügbare Prozessoren und Arbeitsspeicher in einem Cluster und verteilt Daten und Berechnungen auf einzelne Knoten. Durch die Speicherung von Daten im Arbeitsspeicher und die Nutzung der Vorteile einer massiven Parallelverarbeitung wird die Leistung erheblich gesteigert.

8. Netzwerk zur Anzeige von Inhalten (CDN)

CDNs verteilen Inhalte über mehrere geografisch verteilte Server, verkürzen die Ladezeiten und verbessern die Nutzererfahrung weltweit. Dabei werden viele über den ganzen Globus verteilte Server verwendet, um Inhalte für die Nutzer der Website bereitzustellen.

Server wie Cloudflare und Akamai speichern eine Kopie der Website-Informationen im Zwischenspeicher, und die Benutzer, die auf die Website zugreifen, verwenden den CDN-Server und nicht den eigenen Server, wodurch höheres Verkehrsaufkommen bewältigt werden kann.

4. Setzen Sie Automatisierungs- und Überwachungstools ein

Automatisierungswerkzeuge helfen bei der Umsetzung einer Skalierungsstrategie, indem sie die einer Anwendung zugewiesenen Ressourcen auf der Grundlage vordefinierter Metriken und Schwellenwerte automatisch anpassen.

Beliebte Tools, die wir unter anderem für folgende Zwecke verwenden:

- Leistungsüberwachung: New Relic oder Grafana bieten Echtzeiteinblicke in Leistungsprobleme.

- Nachrichten-Warteschlangen: RabbitMQ hilft bei der Verarbeitung von Engpässen in Echtzeit.

- Lasttests: Apache JMeter oder LoadRunner simuliert hohen Datenverkehr, um Schwachstellen aufzudecken.

- Code-Profiling: JProfiler für Java oder Py-Spy für Python analysiert die Codeausführung, um Ineffizienzen zu ermitteln.

Kontinuierliche Überwachung und Analyse bieten Einblicke in die Leistung und das Verhalten der Nutzer. Tools wie Splunk oder Grafana Stack helfen Ihnen, Traffic-Muster zu verstehen und vorherzusagen, sodass Sie wichtige Skalierungsentscheidungen treffen können.

5. Wenden Sie Kostenoptimierungstechniken anwenden

Kostenoptimierungstechniken helfen dabei, unnötige oder übermäßige Kosten im Zusammenhang mit der Skalierung von Cloud-Anwendungen zu reduzieren oder zu vermeiden. Zum Beispiel können Sie:

- den richtigen Cloud-Anbieter und das richtige Preismodell für Ihre Anwendung wählen, indem Sie Cloud-native Services und Funktionen nutzen, die Skalierbarkeit, Leistung und Sicherheit zu geringeren Kosten bieten,

- Entwurfsprinzipien beachten und auf Best Practices für die Anwednungsskalierbarkeit zurückgreifen, die die Leistung, Modularität und Wartbarkeit von Anwendungen verbessern,

- eine DevOps-Kultur und -Methodik einführen, die eine kontinuierliche Integration, Bereitstellung und Rückmeldung ermöglicht,

- Regelmäßige Überprüfungen und Audits von Cloud-Konten und Nutzungsberichten vornehmen, um Korrekturmaßnahmen zu ergreifen.

6. Testen und bewerten Sie Skalierungslösungen

Das Testen und Bewerten von Skalierungslösungen kann auch dazu beitragen, die Auswirkungen von Skalierungsentscheidungen auf die Anwendungsleistung, die Verfügbarkeit und die Kosten zu messen. Es sollten verschiedene Tests wie Lasttests, Stresstests, Ausfallsicherheitstests oder Chaostests durchgeführt werden, um verschiedene Szenarien und Bedingungen zu simulieren, die sich auf die Anwendungsskalierung auswirken.

Testergebnisse und Rückmeldungen sollten ebenfalls gesammelt, analysiert und zur Verbesserung von Skalierungslösungen verwendet werden.

Skalieren mit Blick auf die Zukunft

Wir hoffen, dass die oben genannten Tipps Ihnen helfen, Ihre Anwendungsentwicklung zu bewältigen, unabhängig davon, ob Sie gerade mit einem Nachfrageschub konfrontiert sind oder einen solchen Anstieg planen.

Es ist zu bedenken, dass die Skalierbarkeit aus geschäftlicher Sicht ein kritischer Prozess ist. Während Sie daran arbeiten, Ihre Anforderungen an die Anwendungsentwicklung zu erfüllen, ist es wichtig, jetzt darüber nachzudenken, wie Sie Ihr Wachstum langfristig aufrechterhalten können. Wenn Sie Hilfe bei der Lösungsarchitektur benötigen, wenden Sie sich an unsere Experten. Wir helfen Ihnen gerne bei der Planung und Umsetzung Ihrer Strategie zur Anwendungsskalierung.